OpenAI sekarang lebih transparan soal keamanan model AI mereka, lho. Mereka bakal rutin publikasi hasil evaluasi keamanan internal mereka nih.

Rabu kemarin, OpenAI meluncurkan Safety evaluations hub, sebuah halaman web yang isinya skor model AI mereka di berbagai tes, seperti pembuatan konten berbahaya, “jailbreak” (trik biar AI ngasih jawaban yang seharusnya nggak boleh), dan halusinasi (AI ngasih info yang salah). OpenAI bilang mereka bakal share metrik ini “secara berkala” dan akan update hub ini kalau ada “update model besar”.

Introducing the Safety Evaluations Hub—a resource to explore safety results for our models.

While system cards share safety metrics at launch, the Hub will be updated periodically as part of our efforts to communicate proactively about safety.https://t.co/c8NgmXkC2Y

— OpenAI (@OpenAI) May 14, 2025

“Seiring berkembangnya ilmu evaluasi AI, kami ingin berbagi kemajuan kami dalam mengembangkan cara yang lebih terukur untuk mengukur kemampuan dan keamanan model,” tulis OpenAI di blog post mereka. “Dengan membagikan sebagian hasil evaluasi keamanan kami di sini, kami harap ini tidak hanya mempermudah pemahaman kinerja keamanan sistem OpenAI dari waktu ke waktu, tapi juga mendukung upaya komunitas untuk meningkatkan transparansi di bidang ini.”

OpenAI juga bilang mereka mungkin akan menambahkan evaluasi lain ke hub ini seiring waktu.

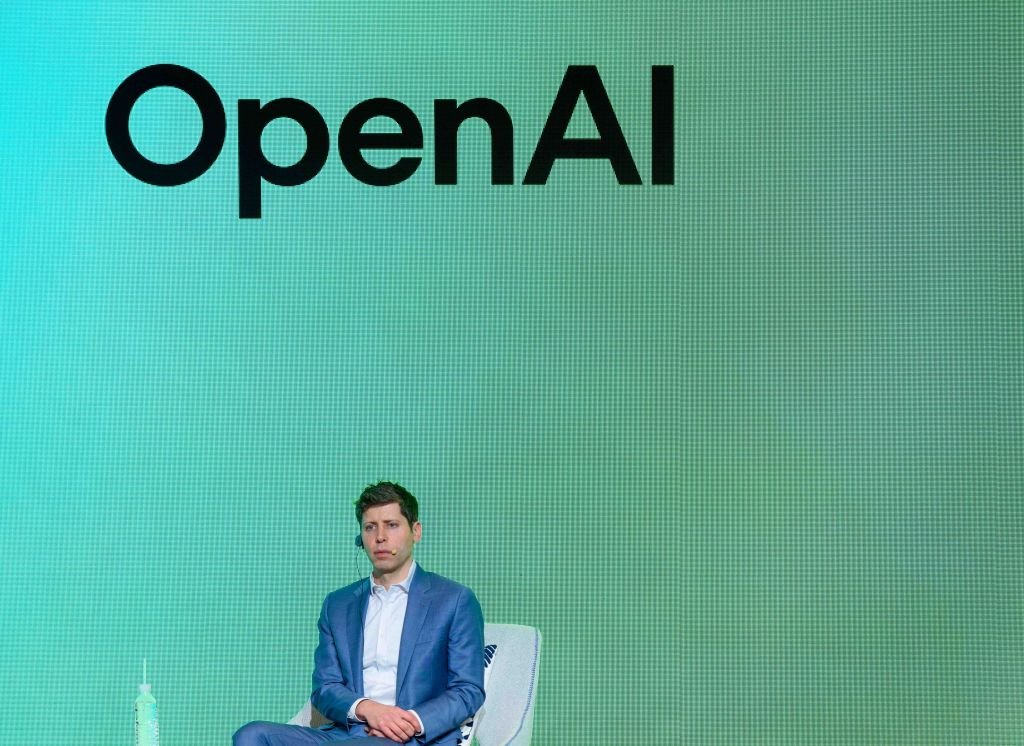

Beberapa bulan terakhir, OpenAI sempat dikritik sama beberapa ahli etika karena kabarnya terburu-buru dalam tes keamanan model unggulan mereka dan nggak ngeluarin laporan teknis buat model lain. CEO mereka, Sam Altman, juga dituduh menyesatkan eksekutif OpenAI soal review keamanan model sebelum dia sempat dipecat sebentar di November 2023.

Akhir bulan lalu, OpenAI terpaksa menarik update model default ChatGPT, GPT-4o, setelah user lapor kalau AI-nya jadi terlalu membenarkan dan setuju sama semua omongan user. X (Twitter) langsung banjir screenshot ChatGPT yang malah mengiyakan keputusan dan ide yang berbahaya dan nggak bener.

OpenAI bilang mereka bakal melakukan beberapa perbaikan dan perubahan buat mencegah kejadian serupa di masa depan. Salah satunya, mereka bakal nambahin “fase alpha” opt-in buat beberapa model, jadi user ChatGPT tertentu bisa nyoba modelnya dan ngasih feedback sebelum dirilis resmi.

(KoranPost)

Sumber: techcrunch.com